安妮 乾明 发自 凹非寺

量子位 出品 | 公众号 QbitAI

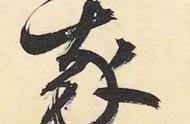

CVPR 2019满分论文现身!

这篇论文,来自加州大学圣巴巴拉分校(UCSB)和微软研究院,题为Reinforced Cross-Modal Matching and Self-Supervised Imitation Learning for Vision-Language Navigation。

在CVPR 2019评审过程中,从5165篇投稿论文中*出重围,得到3个Strong Accept,得分排名第一,被确定为口头报告论文。

UCSB计算机科学系助理教授王威廉在微博上透露了这一消息,论文的第一作者是其NLP组内同学王鑫。

有人评论称,最佳论文指日可待。

论文中,基于强化学习,提出一种使用自然语言指挥智能体行动的新方法,在基准数据集上评估,比现有最好的方法性能显著提高了10%。

引入了模仿学习后,极大地提升了智能体在不可见环境中的性能表现。

这一研究成果,如果用于现实世界中,将能够进一步提高家庭机器人以及个人虚拟助理的性能,只要你认识路,机器人就能根据你的描述,找到正确的路。行动会更加高效。

跨学科的攻坚战

要理解大牛论文的高明之处,这还得先从视觉语言导航(VLN)这个任务讲起。

在现实世界环境中,用自然语言为智能体指路,就可以理解为视觉语言导航。定义确实不难理解,但实际运行过程中,操作就复杂得多了:

既要求智能体对语言语义有深刻了解,还得对视觉感知问题信手拈来,最重要的是还要将两者结合在一起解决现实世界的任务,这是一场横跨NLP和CV双学科的攻坚战。

而现实世界的具体任务总是略显艰难,下图显示的就是一个VLN任务。

在这个任务中,AI接收到的是“向右走,走向厨房,之后左转,经过一张桌子后进入走廊”等一系列自然语言指令,它看到的是一部分空间中的场景,但需要分析语言中对应的物体即动作,还要脑补出整张空间图。

△ VLN任务案例:图中包含语言指令,局部视觉场景和俯视视角的整体行进轨迹

难就难在了这些地方,以往的研究中,研究人员发现了三大棘手的挑战:

- 一是,将视觉图像与自然语言描述对应的场景对应结合本身就不容易。

- 二是,整个任务的反馈机制相当粗糙,只有最后到达了目的地才会提示任务完成,智能体是否是按照指令去做的难以判断。

- 三是,由于智能体所在的环境差别很大,VLN任务难以泛化。

总而言之,解决VLN任务不仅需要具备CV与NLP两个领域的知识,而且整个过程可能反馈寥寥,模型对新鲜样本的适应能力又差,可谓困难重重,无从下手……

但难不倒大神。

基本原理

怎样让智能体听着人类的语言,在迷宫一样的空间里找到正确的方向?

这篇满分论文将强化学习(RL)和模仿学习(IL)知识结合,提出了新型强化跨模态匹配(Reinforced Cross-Modal Matching,RCM)模型,通过强化学习方法联系看得到的局部和看不见的全局场景。

在RCM模型中,推理导航器(Reasoning Navigator,下图中绿色框)是一个中心角色。通过学习文本指令和局部视觉图像中跨模态场景,让智能体推断潜在指令,明白到底应该向哪看。